Ollama 설치 방법: 초보자도 따라할 수 있는 가이드 (deepseek-r1 로컬에서 사용하기)

Ollama는 로컬에서 대형 언어 모델(LLM)을 실행할 수 있도록 도와주는 도구입니다. 이번 시간에는 초보자도 쉽게 Ollama를 설치하고 실행할 수 있도록 단계별로 설명드려 보겠습니다.

1. Ollama란?

Ollama는 로컬 환경에서 AI 모델을 실행할 수 있도록 도와주는 프로그램으로, 인터넷 연결 없이도 AI 기능을 활용할 수 있습니다. MacOS, Windows, Linux에서 사용할 수 있으며, 다양한 AI 모델을 쉽게 다운로드하고 실행할 수 있습니다. Ollama 이외에도 LM Studio, GPT4All, Msty 등의 더 사용자 친화적인 프로그램들이 있지만 Ollama는 회사에서도 무료로 사용할 수 있는 라이선스라는 것이 장점이라고 할 수 있습니다.

2. Ollama 설치하기

Step1. Ollama 공식 웹사이트에 접속한 후, Download 버튼을 클릭합니다.

Step2. "Download for Windows" 버튼을 클릭하여 설치 파일을 다운로드합니다.

Step3. 다운로드한 파일을 실행하시고 "Install" 버튼을 클릭해주세요.

Step4. 설치가 완료되면 설치창이 사라지고 화면 우측 하단에 "Ollama is running" 이라는 팝업창이 출력됩니다.

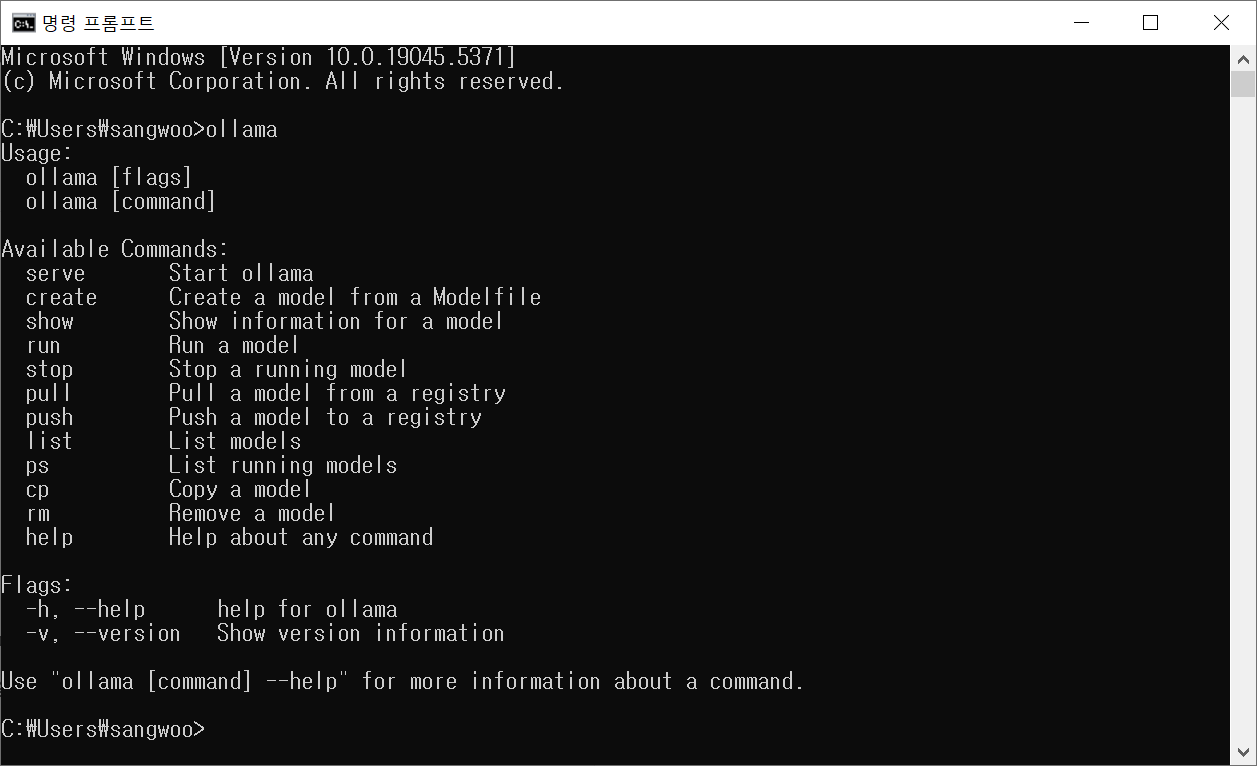

Step5. "명령 프롬프트(CMD)"를 열고 다음 명령어를 입력하여 설치 여부를 확인합니다.

ollama

아래 명령어로 설치된 ollama 버전을 확인할 수 있습니다. ('25.01.30 기준 0.5.7 버전)

ollama -v

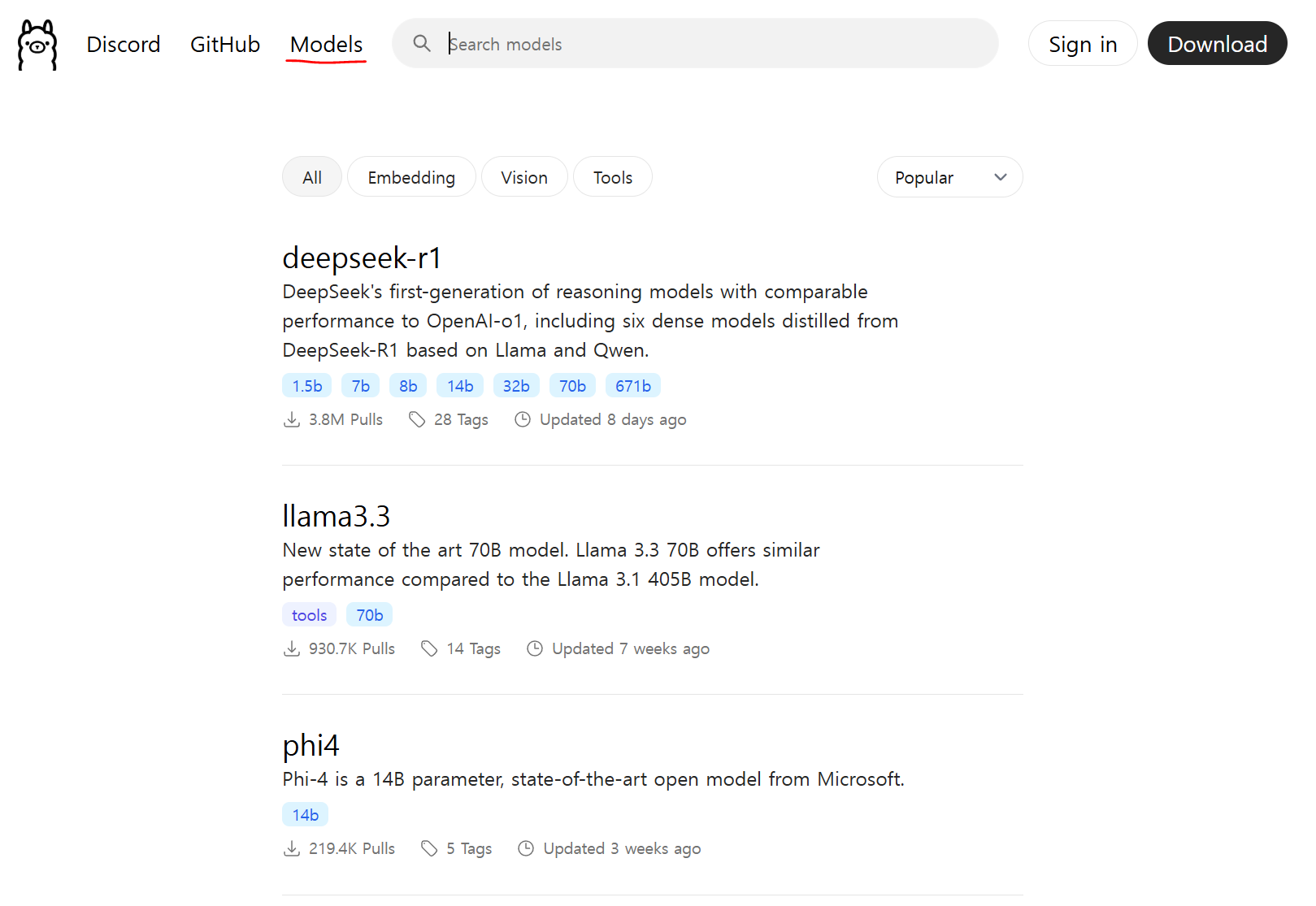

3. Ollama AI 모델 선택해서 설치하기

Ollama 페이지에서 "Models" 탭을 클릭해보면 Ollama를 통해 사용가능한 Local AI 모델들이 있습니다. 최근 중국에서 저비용으로 ChatGPT o1 수준의 로컬 모델을 발표해서 많은 화제가 되었던 deepseek 모델도 보입니다.

참고로 각 모델의 하단에 파란색 사각형으로 표시된 1.5b, 7b, 8b, 14b, 32b, 70b, 671b는 AI 모델의 파라미터 개수를 뜻합니다. 쉽게 말해서 모델의 크기라고 생각하시면 되는데 보통 10b 정도가 일반적인 컴퓨터에서 실행되면서도 의미 있는 대답을 받을 수 있는 파라미터 크기라고 보시면 되겠습니다. 다만 일반적인 컴퓨터가 다소 주관적인 표현이므로 적당한 파라미터부터 설치해서 사용해보시면서 내 컴퓨터에서 돌아갈 수 있는 가장 좋은 모델을 찾아서 사용하시는 것을 추천드립니다.

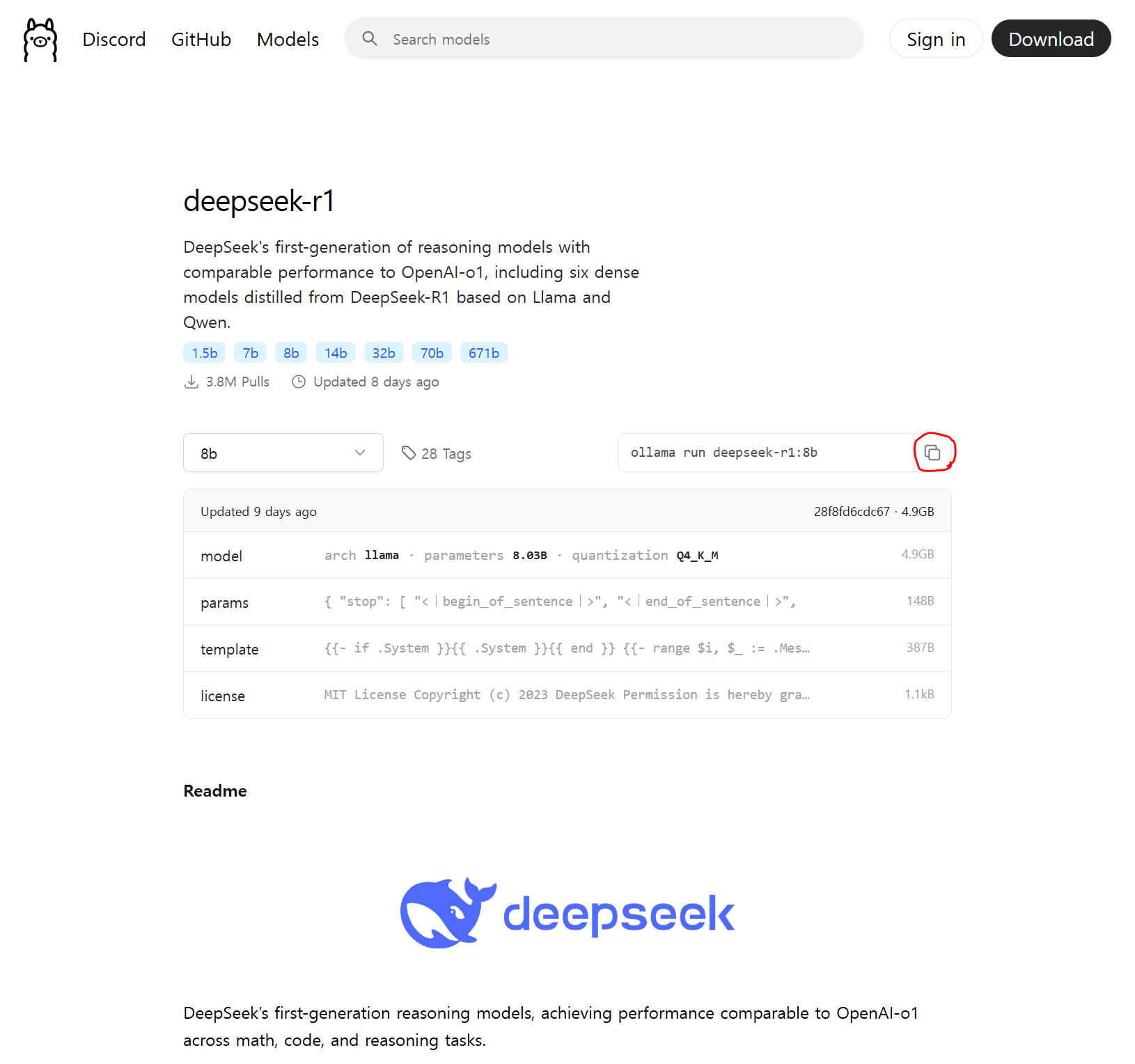

Step1. "Models" 탭을 클릭한 후, 마음에 드는 모델을 클릭해주세요. 저의 경우에는 가장 성능이 좋다고 소문난 deepseek-r1 모델을 선택했습니다.

Step2. 적당한 파라미터를 선택한 후, 우측의 ollama 명령을 복사하기 버튼을 클릭해서 복사해주세요. (저는 8b를 선택하였습니다.)

ollama pull deepseek-r1:8b

Step4. 모델 다운로드가 완료되면 다음 명령어를 입력하여 실행할 수 있습니다. 저의 경우 설치를 run으로 이미 진행했기 때문에 아래와 같이 "success"라는 설치 완료를 알리는 메시지 후에 바로 ">>> Send a message (/? for help)"라는 메시지가 나타났습니다.

ollama run deepseek-r1:8b

이제 Ollama가 AI 모델을 실행하며, 터미널에서 AI와 직접 대화할 수 있습니다. 질문을 입력하고 Enter를 눌러 AI의 응답을 받아볼 수 있습니다.

> What is DeepSeek-R1?4. Ollama 추가 명령어

1) 실행 중인 모델을 종료하려면 Ctrl + C를 누릅니다.

2) 모델 목록을 확인하려면 "ollama list"를 입력합니다.

ollama list이번 시간에는 Ollama를 성공적으로 설치하고, AI 모델을 실행하는 방법을 익혀보았습니다. 이를 통해 로컬 환경에서 강력한 AI 모델을 활용하여 생산성을 높이고, 데이터를 보호하면서 AI를 사용할 수 있습니다. 다음 시간에는 터미널이 익숙하지 않은 사용자분들을 위해서 Ollama UI 또는 Chatbox AI 같은 GUI 프로그램을 통해서 로컬 AI 모델을 사용하는 방법에 대해서 알아보겠습니다.

[이어서 보면 좋은 글]

2025.01.30 - [AI] - [Chatbox AI] 오픈소스 LLM을 로컬에서 사용하는 방법 (feat.Ollama)